Информация на выходе канала связи

Рассмотрим дискретный канал связи. Пусть на его входе формируются дискретные сообщения с использованием алфавита из m символов х1, x2, ..., xm, вероятности которых равны р(x1), р(х2), ..., р(xm). Рассматривая появление символа алфавита как реализацию случайной величины  можно найти энтропию сообщения на входе канала связи

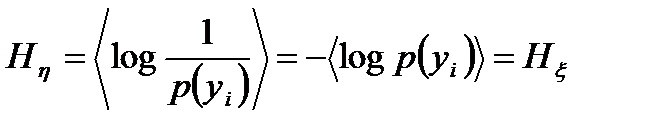

можно найти энтропию сообщения на входе канала связи

, (3.1)

, (3.1)

определяющую среднее количество информации, приходящейся на один символ входного сообщения.

Пусть в канале связи отсутствуют помехи. Тогда между символами на входе (x1, x2, ..., хm) и выходе (y1, y2, ..., ym) существует жёсткая связь. Это означает, что р(у1) = р(x1), p(y2) = Р(х2), .... р(ym) = р(хm) и энтропия на выходе

(3.2)

(3.2)

равна энтропии на входе (рис. а).

Из (3.2) следует, что при отсутствии помех среднее количество информации, приходящейся на одни символ выходного сообщения, равно среднему количеству информации, приходящейся на один символ входного сообщения, при условии, что алфавиты входного и выходного сообщений совпадают.

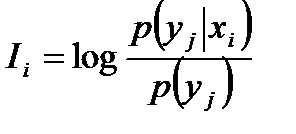

Пусть в канале связи действуют помехи (рис. б). В этом случае появление символа уj на выходе может быть не только под действием символа xj на входе, но, вообще говоря, под действием любого хi входного символа. Это возможно потому, что сигнал, соответствующий какому-либо входному символу, может быть так искажён, что на выходе он будет восприниматься как сигнал, соответствующий другому символу. В этом случае количество информации которое заключено в символе уj, когда на входе действует символ хi, определится по формуле

, (3.3)

, (3.3)

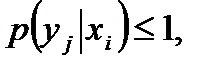

в которой p(yj) соответствует вероятности появления символа уj без учета действия помех. Так как в этом случае р(уj) = P(xj), то р(yj) следует рассматривать как априорную вероятность Р1 в формуле (3.1). В общем случае условная вероятность р(уj|х1) всегда меньше единицы :

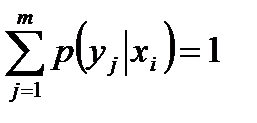

так как из точки хi графа на рис. 18.1,б выходят ветви во все символы выходного алфавита и имеет место равенство

.

.

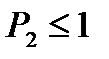

Условную вероятность р(yj|xi) следует рассматривать как апостериорную вероятность Р2 в формуле (3.1), считая, что  то есть приход символа уj не устраняет полностью имевшуюся ранее неопределённость о том, какой символ должен появиться.

то есть приход символа уj не устраняет полностью имевшуюся ранее неопределённость о том, какой символ должен появиться.

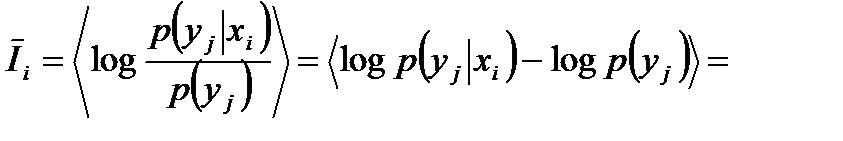

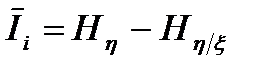

Усреднив выражение (3.3) по всем возможным символам входного и выходного алфавита, то есть по всем i и j индексам, получим среднее количество информации, приходящееся на один символ сообщения на выходе канала связи:

, (3.4)

, (3.4)

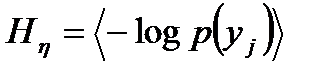

где  - энтропия сообщения на выходе канала связи при отсутствии помех,

- энтропия сообщения на выходе канала связи при отсутствии помех,  - условная энтропия выходного сообщения, характеризующая действие помех.

- условная энтропия выходного сообщения, характеризующая действие помех.

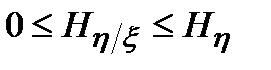

Условная энтропия  , всегда заключена в пределах

, всегда заключена в пределах

. (3.5)

. (3.5)

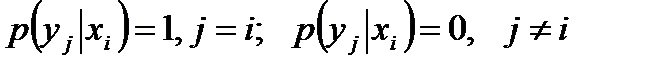

Действительно, если уj и хi жёстко связаны между собой, как это имеет место при отсутствии помех в канале связи (рис. а), то

.

.

В этом случае  .

.

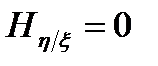

При сильной помехе, когда символы уj возникают на приёмном конце связи независимо от посылаемых хi, имеют место равенства:

.

.

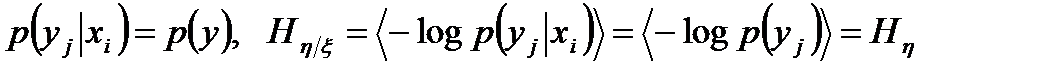

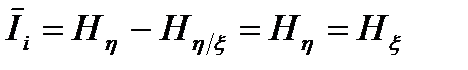

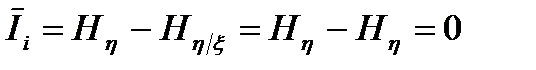

Таким образом, при отсутствии помехи количество информации, приходящееся на один символ выходного сообщения, совпадает с энтропией входного сообщения

. (3.6)

. (3.6)

А при сильной помехе информация, заключённая в символе хi, оказывается совершенно "размазанной" по всем символам уj, так что в среднем выходной символ уj никакой информации об хi не несет и количество информации, которое в среднем приходится на один символ сообщения уj, равно нулю:

. (3.7)

. (3.7)

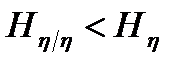

С уменьшением уровня помехи указанная "размазанность" уменьшается, что математически соответствует выполнению неравенства  . Поэтому в среднем по каналу связи один выходной символ передаёт информацию, определяемую выражением (3.4):

. Поэтому в среднем по каналу связи один выходной символ передаёт информацию, определяемую выражением (3.4):

. (3.8)

. (3.8)

Это меньше, чем информация, заключенная в одном символе входного сообщения. Указанное уменьшение информации, обусловленное действием помехи, учитывается условной энтропией  .

.

Заметим, что формулы (3.4), (3.5), (3.7), (3.8) в полной мере справедливы и для непрерывного канала связи. В теоретической литературе иногда количество информации, заключённое в символе уj относительно символа хi и определяемое формулой (3.8), называется взаимной информацией.

Дата добавления: 2016-01-26; просмотров: 1554;