ПРИМЕЧАНИЕ------------------------------------------------------------------------------------------------------- 1 страница

Понятие информации

1.1.1. Определение информации

Термин «информация» происходит от латинского «informatio», что означает «разъяснение», «осведомление», «изложение».

Существует множество определений информации. Так, один из основоположников современной теории информации, Ноберт Винер, определял информацию так: «Информация есть информация, а не материя или энергия».

Такое определение через отрицание кажется достаточно полным и универсальным, но применить его в качестве инструмента для построения научной методологии практически невозможно.

В то же время в современной технике получили широкое распространение методологические подходы, позволяющие применять понятие информации и предложенные инструменты для исследования процессов, происходящих в технических системах, экономике, социуме, в живой и неживой природе.

Наиболее известный среди таких подходов — математическая теория Клода Шеннона, позволяющая вероятностно обосновать надежность передачи сигналов по линии связи. В подходе Шеннона информация — это мера снижения неопределенности системы.

Существует также термодинамический (энергетический) подход, рассматривающий информацию как способ уменьшения энтропии системы.

Советским математиком Колмогоровым был предложен алгоритмический подход, позволяющий оценить информацию по сложности алгоритма, необходимого для ее обработки. Все эти подходы тесно связывали понятие информации со сферой применения.

С позиции материалистической философии информация есть отражение реального мира с помощью сведений (сообщений). Сообщение — это форма представления информации в виде речи, текста, изображения, цифровых данных, графиков, таблиц и т. п. В широком смысле информация — это общенаучное понятие, включающее в себя обмен сведениями между людьми, обмен сигналами между живой и неживой природой, людьми и устройствами.

1.1.2. Информация и данные

Информатика рассматривает информацию как концептуально связанные между собой сведения, понятия, изменяющие наши представления о явлении или объекте окружающего мира. Наряду с информацией в информатике часто употребляется понятие данных. Покажем, в чем их различие.

Данные могут рассматриваться как признаки или записанные наблюдения, которые по каким-то причинам не используются, а только хранятся. В том случае, если появляется возможность использовать эти данные для уменьшения неопределенности знаний о чем-либо, данные превращаются в информацию.

Пример. Напишите на листе бумаги десять номеров телефонов в виде последовательности десяти чисел и покажите их вашему другу. Он воспримет эти цифры как данные, так как они не предоставляют ему никаких сведений. Затем против каждого номера укажите название фирмы и род деятельности. Для вашего друга непонятные цифры обретут определенность и превратятся из данных в информацию, которую он в дальнейшем мог бы использовать.

1.1.3. Адекватность информации

При работе с информацией всегда имеются ее источник и потребитель (получатель). Пути и процессы, обеспечивающие передачу сообщений от источника информации к ее потребителю, называются информационными коммуникациями.

Для потребителя информации очень важной характеристикой является ее адекватность.

|

В реальной жизни вряд ли возможна ситуация, когда вы сможете рассчитывать на полную адекватность информации. Всегда присутствует некоторая степень неопределенности. От степени адекватности информации реальному состоянию объекта или процесса зависит правильность принятия решений человеком.

Адекватность информации может выражаться в трех формах: семантической, синтаксической, прагматической.

Синтаксическая адекватность отображает формально-структурные характеристики информации и не затрагивает ее смыслового содержания. На синтаксическом уровне учитываются тип носителя и способ представления информации, скорость передачи и обработки, размеры кодов представления информации, надежность и точность преобразования этих кодов и т. п. Информацию, рассматриваемую только с синтаксических позиций, обычно называют данными, так в этой форме смысловая сторона не имеет значения. Эта форма способствует восприятию внешних структурных характеристик, то есть синтаксической стороны информации.

Семантическая (смысловая) адекватность определяет степень соответствия образа объекта и самого объекта. Семантический аспект предполагает учет смыслового содержания информации. На этом уровне анализируются те сведения, которые отражает информация, рассматриваются смысловые связи. В информатике устанавливаются смысловые связи между кодами представления информации. Эта форма служит для формирования понятий и представлений, выявления смысла, содержания информации, для ее обобщения.

Прагматическая (потребительская) адекватность отражает отношение информации и ее потребителя, соответствие информации цели управления, которая на ее основе реализуется. Проявляются прагматические свойства информации только при наличии единства информации (объекта), пользователя и цели управления. Прагматический аспект рассмотрения связан с ценностью, полезностью использования информации при выработке потребителем решения для достижения своей цели. С этой точки зрения анализируются потребительские свойства информации. Эта форма адекватности непосредственно связана с практическим использованием информации, с соответствием ее целевой функции деятельности системы.

1.2. Меры информации

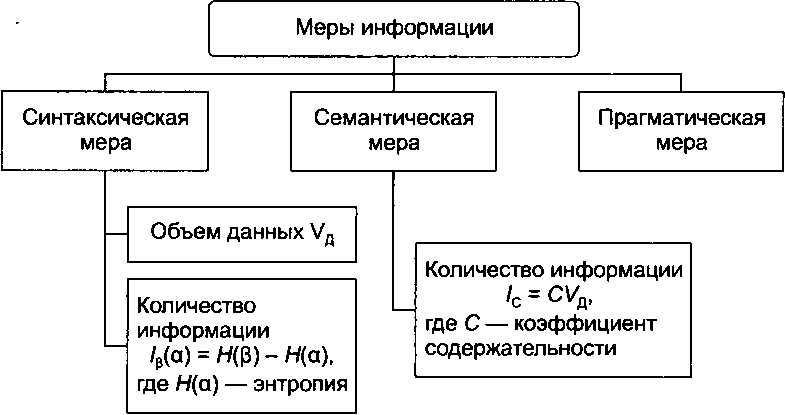

Для измерения информации вводятся два параметра: количество информации I и объем данных Vr.

Эти параметры имеют разные выражения и интерпретацию в зависимости от рассматриваемой формы адекватности. Каждой форме адекватности соответствует своя мера количества информации и объема данных (рис. 1.1).

Рис. 1.1. Меры информации

Рис. 1.1. Меры информации

|

1.2.1. Синтаксическая мера информации

Синтаксическая мера количества информации оперирует обезличенной информацией, не выражающей смыслового отношения к объекту.

Объем данных Va в сообщении измеряется количеством символов (разрядов) в этом сообщении. В различных системах счисления один разряд имеет различный вес и соответственно меняется единица измерения данных:

□ в двоичной системе счисления единица измерения — бит (bit, или binary digit, — двоичный разряд);

□ в десятичной системе счисления единица измерения — дит (десятичный разряд).

ПРИМЕЧАНИЕ-------------------------------------------------------------------------------------------------------

В современных ЭВМ наряду с минимальной единицей измерения данных — битом — широко используется укрупненная единица измерения — байт, равная 8 бит.

Пример. Сообщение в двоичной системе в виде восьмиразрядного двоичного кода 10111011 имеет объем данных Vjx = 8 бит.

Сообщение в десятичной системе в виде шестиразрядного числа 275903 имеет объем данных Vjx = 6 дит.

Количество информации I на синтаксическом уровне невозможно определить без рассмотрения понятия неопределенности состояния системы (энтропии системы). Действительно, получение информации о какой-либо системе всегда связано с изменением степени неосведомленности получателя о состоянии этой системы. Рассмотрим это понятие.

Пусть до получения информации потребитель имеет некоторые предварительные (априорные) сведения о системе а. Мерой его неосведомленности о системе является функция Я(а), которая в то же время служит и мерой неопределенности состояния системы.

После получения йекоторого сообщения P получатель приобретает некоторую дополнительную информацию /р(а), уменьшающую его априорную неосведомленность так, что апостериорная (после получения сообщения Р) неопределенность состояния системы становится равной Яр(а).

Тогда количество информации /р(а) о системе, полученной в сообщении |3, определится так:

/„(«)-Я(а)-Я„(а),

то есть количество информации измеряется изменением (уменьшением) неопределенности состояния системы.

Если конечная неопределенность Яр(а) обратится в нуль, то первоначальное неполное знание заменится полным знанием и количество информации:

/„(а)-Я(а)

Иными словами, энтропия системы Я(а) может рассматриваться как мера недостающей информации.

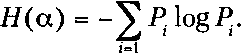

Энтропия системы Я(а), имеющая N возможных состояний, согласно формуле Шеннона, равна:

N

|

Здесь Pi — вероятность того, что система находится в i-м состоянии. Для случая, когда все состояния системы равновероятны, то есть их вероятности 1

равны , ее P = — энтропия определяется соотношением

N л 4

Ж а) =-У-log-. tfJV N

Часто информация кодируется числовыми кодами в той или иной системе счисления, особенно это актуально при представлении информации в компьютере. Естественно, что одно и то же количество разрядов в разных системах счисления может передать разное количество состояний отображаемого объекта, что можно представить в виде соотношения

N=mn.

Здесь N- количество всевозможных отображаемых состояний; т — основание системы счисления (разнообразие символов, применяемых в алфавите); п — количество разрядов (символов) в сообщении.

Пример. По каналу связи передается «-разрядное сообщение, использующее т различных символов. Так как количество всевозможных кодовых комбинаций будет N = тп, то при равной вероятности появления любой из них количество информации, приобретенной абонентом в результате получения сообщения, окажется равным

/= IogAZr= п Iogm.

Это формула Хартли.

Если в качестве основания логарифма принять т, то I = п. В данном случае количество информации (при условии полного априорного незнания абонентом содержания сообщения) будет равно объему данных, полученных по каналу связи (/ = Уд). Для неравновероятных состояний системы всегда I < Vjx = Yi.

Наиболее часто используются двоичные и десятичные логарифмы. Единицами измерения в этих случаях являются бит и дит соответственно.

Коэффициент (степень) информативности (лаконичность) сообщения определяется отношением количества информации к объем}- данных:

Y = , причем О < У< 1.

С увеличением Y уменьшаются объемы работы по преобразованию информации (данных) в системе. Поэтому стремятся к повышению информативности, для чего разрабатываются специальные методы оптимального кодирования информации.

1.2.2. Семантическая мера информации

Для измерения смыслового содержания информации, то есть ее количества на семантическом уровне, наибольшее признание получила тезаурусная мера, которая связывает семантические свойства информации со способностью пользователя принимать поступившее сообщение. Для этого используется понятие тезауруса пользователя.

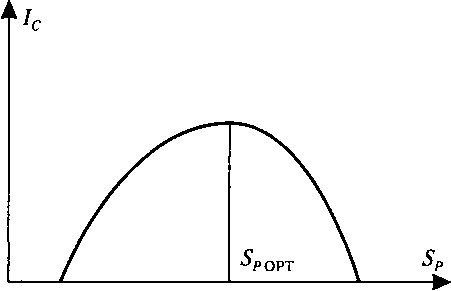

В зависимости от соотношений между смысловым содержанием информации S и тезаурусом пользователя Sp изменяется количество семантической информации Ip1 воспринимаемой пользователем и включаемой им в дальнейшем в свой тезаурус. Характер такой зависимости показан на рис. 1.2. Рассмотрим два предельных случая, когда количество семантической информации Ic равно 0:

□ при Sp ~ 0 пользователь не воспринимает и не понимает поступающую информацию;

□ при Sp а> пользователь все знает, и поступающая информация ему не нужна.

Рис. 1.2. Зависимость количества информации, воспринимаемой пользователем, от его тезауруса Ic = f{SP)

Рис. 1.2. Зависимость количества информации, воспринимаемой пользователем, от его тезауруса Ic = f{SP)

|

Максимальное количество семантической информации Ic потребитель приобретает при согласовании ее смыслового содержания S со своим тезаурусом Sp (Sp = Sp 0рт)> когда поступающая информация понятна пользователю и несет ему ранее неизвестные (отсутствующие в его тезаурусе) сведения.

Следовательно, количество семантической информации в сообщении, то есть количество новых знаний, получаемых пользователем, является величиной относительной. Одно и то же сообщение может иметь смысловое содержание для компетентного пользователя и быть бессмысленным (семантический шум) для пользователя некомпетентного.

При оценке семантического (содержательного) аспекта информации необходимо стремиться к согласованию величин S и Sp.

Относительной мерой количества семантической информации может служить коэффициент содержательности С, который определяется как отношение количества семантической информации к ее объему:

|

1.2.3. Прагматическая мера информации

Прагматическая мера определяет полезность (ценность) информации для достижения пользователем поставленной цели. Эта мера также величина относительная, обусловленная особенностями применения этой информации в той или иной

системе. Ценность информации целесообразно измерять в тех же самых единицах (или близких к ним), в которых измеряется целевая функция.

Пример. В экономической системе прагматические свойства (ценность) информации можно определить приростом экономического эффекта функционирования, достигнутым благодаря использованию этой информации для управления системой:

Здесь — ценность информационного сообщения р для системы управления у ; Я(у) — априорный ожидаемый экономический эффект функционирования системы управления у; Я — — ожидаемый эффект функционирования системы у

IpJ

при условии, что для управления будет использована информация, содержащаяся в сообщении р.

Для сопоставления введенные меры информации представим в табл. 1.1.

Кроме трех перечисленных иногда выделяется еще один класс информационных мер, структурный, в который включают геометрическую, комбинаторную и адаптивную меры.

Адаптивная мера (мера Хартли) уже была рассмотрена в составе синтаксической меры.

Геометрическая мера предполагает измерение параметра геометрической модели информационного сообщение (длины, площади, объема) в дискретных единицах. Например, геометрической моделью информации может быть линия единичной длины, квадрат или куб. Максимально возможное количество информации в заданных структурах определяет информационную емкость модели (систему), которая описывается как сумма дискретных значений по всем измерениям.

В комбинаторной мере количество информации определяется как число комбинаций элементов (символов). Возможное количество информации совпадает с числом возможных сочетаний, перестановок или размещений элементов. Комбинирование символов в словах, состоящих только из 0 и 1, меняет значение слов.

Таблица 1.1. Единицы измерения информации и примеры

|

| Мера информации | Единицы измерения | Примеры (для компьютерной области) |

| Прагматическая | Ценность использования | Емкость памяти, производительность компьютера, скорость передачи данных ИТ. д. Денежное выражение Время обработки информации и принятия решений |

1.3. Качество информации

Под качеством информации понимается такая совокупность свойств, которая обусловливает ее способность удовлетворять определенные потребности людей. Основными потребительскими показателями качества информации являются: репрезентативность, содержательность, достаточность, доступность, актуальность, своевременность, точность, достоверность, устойчивость.

Репрезентативность информации связана с правильностью ее отбора и формирования в целях адекватного отражения свойств объекта. Важнейшее значение здесь имеют

□ правильность концепции, на базе которой сформулировано исходное понятие;

□ обоснованность отбора существенных признаков и связей отображаемого явления.

Нарушение репрезентативности информации приводит нередко к существенным ее погрешностям.

Содержательность информации отражает семантическую емкость, равную отношению количества семантической информации в сообщении к объему обрабатываемых данных:

|

С увеличением содержательности информации растет семантическая пропускная способность информационной системы, так как для получения одних и тех же сведений требуется преобразовать меньший объем данных.

Наряду с коэффициентом содержательности С, отражающим семантический аспект, можно использовать и коэффициент информативности У, характеризующийся отношением количества синтаксической информации (по Шеннону) к объему данных:

|

Достаточность (полнота) информации означает, что ее состав (набор показателей) минимален, но достаточен для принятия правильного решения. Понятие полноты информации связано с ее смысловым содержанием (семантикой) и прагматикой. Как неполная, то есть недостаточная для принятия правильного решения, так и избыточная информация снижает эффективность принимаемых пользователем решений.

Доступность информации восприятию пользователя обеспечивается выполнением соответствующих процедур ее получения и преобразования. Например, в информационной системе информация преобразуется к доступной и удобной для восприятия пользователем форме. Это достигается, в частности, и путем согласования ее семантической формы с тезаурусом пользователя.

Актуальность информации определяется степенью сохранения ценности информации для управления на момент использования и зависит от динамики изменения ее характеристик, а также от интервала времени, прошедшего с момента возникновения данной информации.

Своевременность информации означает ее поступление не позже заранее назначенного момента времени, согласованного с временем решения поставленной задачи.

Точность информации определяется степенью близости получаемой информации к реальному состоянию объекта, процесса, явления и т. п. Для информации, отображаемой цифровым кодом, известны четыре классификационных понятия точности:

□ формальная точность измеряется значением единицы младшего разряда числа;

□ реальная точность определяется значением единицы последнего разряда числа, верность которого гарантируется;

□ максимальная точность представляет собой точность, которую можно получить в конкретных условиях функционирования системы;

□ необходимая точность определяется функциональным назначением показателя.

Достоверность информации определяется ее свойством отражать реально существующие объекты с необходимой точностью. Измеряется достоверность информации доверительной вероятностью необходимой точности, то есть вероятностью того, что отображаемое информацией значение параметра отличается от истинного значения этого параметра в пределах необходимой точности.

Устойчивость информации отражает ее способность реагировать на изменения исходных данных без нарушения необходимой точности. Устойчивость информации, как и репрезентативность, обусловлена выбранной методикой ее отбора и формирования.

В заключение следует отметить, что такие параметры качества информации, как репрезентативность, содержательность, достаточность, доступность, устойчивость, целиком определяются на методическом уровне разработки информационных систем. Параметры актуальности, своевременности, точности и достоверности также в большей степени обусловливаются на методическом уровне, однако на их величину существенно влияет еще и характер функционирования системы, в первую очередь ее надежность. При этом параметры актуальности и точности жестко связаны, соответственно, с параметрами своевременности и достоверности.

1.4. Информационные процессы

Процессы, связанные с поиском, хранением, передачей, обработкой и использованием информации, называются информационными.

^ ''' '' ''''' ^ ^ J ' ' ^ ; i ^ ' ' '' '

Методы поиска информации:

□ непосредственное наблюдение;

□ общение со специалистами по интересующему вас вопросу;

□ чтение соответствующей литературы;

□ просмотр видео, телепрограмм;

□ прослушивание радиопередач, аудиокассет;

□ работа в библиотеках и архивах;

□ запрос к информационным системам, в том числе базам и банкам компьютерных данных;

□ поиск информации в Интернете;

□ другие методы.

|

Способ хранения информации зависит от ее носителя (книга — библиотека, картина — музей, фотография — альбом). ЭВМ может рассматриваться как устройство для компактного хранения информации с возможностью быстрого доступа к ней.

|

В процессе передачи информации обязательно участвуют источник и приемник информации. Между источником и приемником действует канал передачи информации — канал связи. Канал связи — совокупность технических устройств, обеспечивающих передачу сигнала от источника к получателю. Кодирующее устройство — устройство, предназначенное для преобразования исходного сообщения источника к виду, удобному для передачи. Декодирующее устройство — устройство для преобразования кодированного сообщения в исходное (рис. 1.3). Деятельность людей всегда связана с передачей информации. В процессе передачи информация может теряться и искажаться, в качестве примеров можно привести искажение звука в телефоне, атмосферные помехи в радио, искажение или затемнение изображения в телевидении, ошибки при передачи в телеграфе.

Помехи

Рис. 1.3. Передача информации по каналу связи

Рис. 1.3. Передача информации по каналу связи

|

Каналы передачи сообщений характеризуются пропускной способностью и помехозащищенностью. Каналы передачи данных делятся на симплексные (с передачей информации в одну сторону, например телевидение) и дуплексные (по которым можно передавать информацию в оба направления, например телефон, телеграф). По каналу могут одновременно передаваться несколько сообщений. Каждое из этих сообщений выделяется (отделяется от других) с помощью специальных фильтров. Например, возможна фильтрация по частоте передаваемых сообщений, как это делается в радиоканалах. Пропускная способность канала определяется максимальным количеством символов, передаваемых по нему в отсутствие помех. Эта характеристика зависит от физических свойств канала. Для повышения помехозащищенности канала используются специальные методы передачи сообщений, уменьшающие влияние шумов. Например, вводят лишние символы. Эти символы не имеют реального содержания, но используются для контроля правильности сообщения при получении. С точки зрения теории информации избыточно все то, что делает литературный язык красочным, гибким, богатым оттенками, многоплановым, многозначным.

|

После решения задачи обработки информации результат должен быть выдан конечным пользователям в требуемом виде. Эта операция реализуется в ходе решения задачи выдачи информации. Выдача информации, как правило, производится с помощью внешних устройств ЭВМ в виде текстов, таблиц.

Защита информации в более узком смысле понимается как предотвращение доступа к информации лицам, не имеющим соответствующего разрешения (несанкционированный, нелегальный доступ), непредумышленного или недозволенного использования, изменения или разрушения информации.

|

Наиболее эффективным средством организации информационных процессов является информационная система, оснащенная средствами ввода, поиска, размещения, обработки и выдачи информации. Наличие таких средств — главная особенность информационных систем, отличающих их от простых скоплений информационных материалов. Например, личная библиотека, в которой может ориентироваться только ее владелец, информационной системой не является.

В публичных же библиотеках порядок размещения книг всегда строго определен. Благодаря ему, поиск и выдача книг, а также размещение новых поступлений реализованы в виде стандартных, формализованных процедур.

1.5. Кодирование при передаче и хранении информации

Путем кодирования производится отображение одного набора знаков в другой набор знаков. Отображаемый набор знаков называется исходным алфавитом, а набор знаков, который используется для отображения, — кодовым алфавитом. Для построения кода применяются как отдельные символы кодового алфавита, так и их комбинации.

Совокупность символов кодового алфавита, применяемых для кодирования одного символа или одной комбинации символов исходного алфавита, называется кодом символа.

Взаимосвязь символов или комбинаций символов исходного алфавита с их кодовыми комбинациями составляет таблицу кодов (таблицу соответствия).

Для получения исходных символов по кодам символов применяют процедуру декодирования. При этом обязательно соблюдение условия: код должен быть однозначным, то есть одному исходному знаку должен соответствовать точно один код и наоборот.

|

Виды кодирования зависят от поставленной цели.

□ Кодирование по образцу — каждый знак дискретного сигнала представляется знаком или набором знаков того алфавита, в котором выполняется кодирование. Кодирование по образцу используется, например, для ввода информации в компьютер с целью ее внутреннего представления.

Пример. Для перевода символов, вводимых с клавиатуры, в числовой код, хранящийся в памяти компьютера, используется кодовая таблица ASCII (American Standard Code for Information Interchange — американский стандартный код для обмена информацией), в которой каждому символу алфавита, а также множеству специальных управляющих команд соответствует числовой код.

□ Криптографическое кодирование, или шифрование, используется тогда, когда нужно защитить информацию от несанкционированного доступа. Существует два основных широко применяющихся сегодня способа криптографического кодирования: симметричное кодирование с закрытым ключом и асимметричное кодирование с открытым ключом. При симметричном кодировании с закрытым ключом для кодирования и декодирования данных применяется один и тот же ключ. Этот ключ должен быть по безопасным каналам доставлен стороне, осуществляющей декодирование, что делает шифрование с симметричным ключом уязвимым. Напротив, при шифровании с асимметричным ключом сторона, осуществляющая декодирование, публикует так называемый открытый ключ (public key), который применяется для кодирования сообщений, а декодирование осуществляется другим — закрытым ключом (private key), известным только принимающей стороне. Такая схема делает асимметричный способ кодирования высоконадежным. По этой причине в последнее время он приобрел массовую популярность.

Пример. Во множестве шпионских фильмов-боевиков основным вопросом при захвате агента противника было получение ключей к шифрам. Получение ключа давало возможность прочесть все перехваченные ранее сообщения и сразу получить множество полезной информации. Но эта возможность достижима только тогда, когда речь идет о симметричных ключах. Получение публичного асимметричного ключа в этом смысле не дает никаких преимуществ, поскольку открытый ключ позволяет кодировать сообщения, но не может применяться для их декодирования.

□ Оптимальное кодирование служит для устранения избыточности данных путем снижения среднего числа символов кодового алфавита, предназначенных для представления одного исходного символа. Оптимальное кодирование обычно используется в архиваторах. В большинстве современных программ, предназначенных для оптимального кодирования (сжатия) данных, применяются одни и те же базовые алгоритмы:

Дата добавления: 2016-04-14; просмотров: 1183;