Энтропия и информация

Обратимся еще раз к модели ящика с двумя отделениями: в каком случае мы знаем о системе больше — когда она находится в состоянии 0|10 или 5|5? Очевидно, в первом: про каждую молекулу мы можем точно сказать, в каком она отделении — в правом. Если же система находится в состоянии 5|5, то интересующая нас конкретная молекула может с равной вероятностью быть в любом отделении.

Для остальных состояний количество доступной информации о системе будет промежуточным между этими двумя крайними случаями. Например, если нам известно, что состояние системы есть 8|2, то на вопрос «где находится молекула №1?» можно ответить, что с вероятностью 0,8 она в левом отделении — а это означает, что мы знаем больше, чем ничего. Прослеживается четкая связь: чем меньше статистический вес состояния системы, то есть чем меньше энтропия, тем определеннее наши знания о системе.

Энтропия системы есть мера отсутствия информации

о ее внутреннем устройстве.

Поэтому, в силу закона возрастания энтропии:

количество доступной о замкнутой системе информации

с течением времени уменьшается.

Одна из основных дисциплин, определяющих лицо современной науки и технологии, — это теория информации. Она выросла из работ К. Шеннона, опубликованных в 1948—1949 гг., где он дал четкое определение «количества информации».

Исходным для Шеннона было понятие энтропии распределения вероятностей некоторых событий. Под событием можно понимать, например, появление определенной буквы в тексте, передаваемом по каналу связи. До того, как приемник получил значение очередной буквы, на ее месте можно было ожидать появление почти любого символа алфавита. Другими словами, распределение вероятностей событий «на данном месте стоит n-я буква алфавита» было более или менее однородным. Получение буквы, скажем, «А», вносит неоднородность: вероятность того, что на данном месте стоит «А», становится равной единице, а вероятности любых других символов — нулю. Но увеличение неоднородности приводит, как мы уже знаем, к уменьшению энтропии!

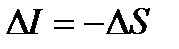

Шеннон определил количество полученной системой информации DI как понижение ее энтропии в результате приема сообщения[36]:

. .

|

Это определение, основанное на понимании энтропии как меры отсутствия информации, оказалось чрезвычайно плодотворным и представляет собой теоретическую основу всех современных технологий передачи, хранения и обработки информации.

Дата добавления: 2015-01-13; просмотров: 924;