Информация, количество и качество

Информация – один из популярных терминов в нашем лексиконе. В него вкладывается довольно широкий смысл, а его восприятие чаще всего интуитивно. Большой энциклопедический словарь (М., 1998) дает следующее определение информации: «Информация (от лат. informatio – разъяснения, изложение), первоначально – сведения, передаваемые людьми устным, письменным или другим способом (с помощью условных сигналов, технических средств и т.д.), с середины 20 в. общенаучное понятие, включающее обмен сведениями между людьми, человеком и автоматом, автоматом и автоматом; обмен сигналами в животном и растительном мире…; – одно из основных понятий кибернетики.» Как видим, это определение отражает смысловой сдвиг в понимании термина информация, произошедший за последнюю половину века. Желая подчеркнуть особую, нематериальную сущность информации, Норберт Винер сказал: « Информация есть информация, не материя и не энергия». Информацию можно хранить, преобразовывать (обрабатывать) и передавать, у нее должен быть источник, материальный носитель, передатчик, канал связи и приемник.

В общении мы часто употребляем термин «данные» как синоним информации, однако между ними есть существенное различие. Данные – это величины, их отношения, словосочетания (тексты), преобразование и обработка которых позволяют извлечь ту или иную информацию (знание) о некотором предмете, явлении, процессе. Данные в этом аспекте служат «сырьем» для получения информации.

Исследованием методов хранения, передачи и приема информации, а также оценки ее количества и качества занимается теория информации. Математические основы теории информации составляют теория кодирования, теория случайных процессов, математическая статистика, теория вероятностей. Основоположниками теории информации являются Н. Винер, К. Шеннон, Р. Хартли, значительный вклад в теорию информации внесли отечественные ученые А.Н. Колмогоров, А.А. Харкевич, В.А. Котельников и др.

Важнейшим понятием теории информации является количественная оценка информации. Эта оценка дает возможность измерить информационные потоки в информационных системах независимо от их природы и физической реализации. Один из подходов к оценке количества информации основан на следующих соображениях.

Предположим, что получателя информации интересует, в каком из N возможных состояний находится интересующий его объект. Если у получателя нет никаких сведений о состоянии объекта, то количество требуемой для этого информации можно считать равным уменьшению неопределенности состояния объекта.

Эта мера в теории информации называется энтропией по аналогии с физикой, где энтропия характеризует степень неупорядоченности (хаотичности) физической системы. Неупорядоченность может быть интерпретирована в смысле того, насколько мало получателю информации известно о данной системе. Если наблюдатель выявил что-нибудь в физической системе, ее энтропия для наблюдателя снизилась. В нашем случае максимум энтропии соответствует отсутствию информации о состоянии объекта. Минимум энтропии (ноль) соответствует полной информации о состоянии объекта.

Таким образом, энтропия и объем информации имеют противоположные знаки. Если объект может находиться в двух равновероятных состояниях (N = 2), то говорят, что для снятия неопределенности о его состояниях требуется единица информации. Такая единица получила название бит (binary digit-bit), т.е. бит информации сужает область выбора вдвое. Аналогично для N = 4 достаточно двух бит и т.д.

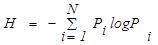

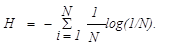

По формуле Шеннона, энтропия объекта, имеющего N возможных состояний, равна

где Рi – вероятность нахождения объекта в i-м состоянии.

Если все N состояний объекта равновероятны, энтропия равна

При кодировании информации в той или иной позиционной системе счисления, число различных состояний, кодируемых n разрядами, равно

N=qn

где q – основание системы счисления;

n – число разрядов.

При передаче n-разрядного сообщения, записанного в системе с основанием q, получателем будет воспринято количество информации, равное:

I = log N = nlog q – формула Хартли.

Если в качестве основания логарифма принять q, то I = n, т.е. количество информации, воспринятой получателем (при его полном априорном незнании содержания сообщения), будет равно числу разрядов в сообщении (объему данных) I= n= VД, где VД – объем данных.

Если появление различных кодовых комбинаций в сообщении не равновероятно, то естественно, что I < VД.

Обратим внимание на другую сторону измерения количества информации. Она связана с той или иной потребностью получателя информации, о которой отправитель сообщения может и не знать.

Всем известно, что некий оратор может говорить очень долго, например передать содержание нескольких десятков страниц текста (десятки тысяч знаков), а неопределенность, снимаемая его сообщением, может составлять всего несколько бит.

Измерения только количества информации в наше время (лавинообразного нарастания ее потоков) уже недостаточно. Потребности управления, науки и техники требуют решения проблемы содержательности информации и ее ценности.

В одной из работ предлагается принять за меру ценности информации ее количество, необходимое для достижения поставленной цели.

Если до получения информации вероятность достижения цели ее получателем равнялась Р0, а после ее получения – Pi, то ценность информации можно определить как:

C=log (Pi/P0).

В других работах, кроме вероятностных характеристик неопределенности состояния объекта до и после получения информации, вводятся функции штрафов и потерь. Оценка информации производится по результатам их минимизации. Рассматривается и случай, когда ценность информации становится отрицательной (за счет дезинформации или неполноты информации). Ценность информации связывается с конкретной задачей, для которой она получается.

Попытки построить семантическую (смысловую) теорию ценности информации исходят еще от Н. Винера. Его идея состоит в том, что эффективность использования информации зависит от уровня знаний ее получателя. Если назвать совокупность знаний получателя о некотором предмете тезаурусом, то количество и ценность информации в некотором сообщении можно оценить степенью изменения тезауруса получателя под воздействием сообщения.

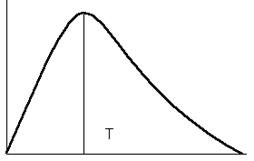

Зависимость количества информации Ic, включаемого пользователем в свой тезаурус после получения некоторого сообщения, от величины этого тезауруса Tn в момент получения сообщения можно представить графиком на рисунке.

Ic

Tn

Tn

Максимальное количество информации получатель приобретает (включает в свой тезаурус), обладая достаточно большим (развитым), но еще не полным тезаурусом. При ТП = 0 получатель не способен воспринимать информацию. При ТП = ТП полн., т.е. при полном знании о некотором объекте, получатель не нуждается в поступающей информации.

Качество информации определяется и другими показателями, обеспечивающими возможность ее эффективного использования, вне зависимости от тезауруса получателя.

Среди таких показателей важнейшие:

- релевантность информации (от английского relevant – уместный, относящийся к делу) отражает соответствие сообщения поступившему запросу;

- репрезентативность информации (от французского representatif – представительный) означает правильность выбора частных показателей в целях отражения характеристик объекта в целом;

- полнота информации характеризует сообщение с точки зрения достаточности набора показателей для принятия решения;

- актуальность информации определяется степенью сохранения ее ценности на момент принятия решения;

- точность информации определяется ее адекватностью реальному состоянию некоторого объекта.

Дата добавления: 2014-12-02; просмотров: 2682;