Количество информации можно рассматривать как меру уменьшения неопределенности знания при получении информационных сообщений.

В настоящее время получили распространение подходы к определению понятия "количество информации", основанные на том, что информацию, содержащуюся в сообщении, можно нестрого трактовать в смысле её новизны или, иначе, уменьшения неопределённости наших знаний об объекте. Эти подходы используют математические понятия вероятности и логарифма. Логарифм числа - это показатель степени, в которую надо возвести основание, чтобы получить данное число.

В 1927 году Робертом Хартли предложена логарифмическая мера количества информации.

I = n loga m

Количество информации, передаваемое в сообщении, состоит из n символов, каждый символ может принимать m значений, при этом, Роберт Хартли предполагал, что все состояния равновероятны.

Если принять основание логарифма равным а=2, что является наиболее удобным в цифровой технике, поскольку используются технические элементы, имеющие, как правило, два состояния, то процесс получения информации для одного символа из конечного наперёд заданного множества N равновероятных символов, имеет следующий вид.

I = log2N

Допустим, нужно угадать одно число из набора чисел от единицы до ста. По формуле Хартли можно вычислить, какое количество информации для этого требуется:

I = log2100 > 6,644 единицы информации

Таким образом, сообщение о верно угаданном числе содержит количество информации, приблизительно равное 6,644 единицы информации.

Клод Шеннон снял ограничение, основанное на равновероятных событиях, и ввел вероятность состояния m. В 1948 г. он предложил другую формулу определения количества информации, учитывающую возможную неодинаковую вероятность событий, например символов в сообщении.

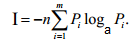

Формула Шеннона для среднего количество информации, приходящегося на сообщение из n символов при условии, что каждый символ может принимать m значений

где pi — вероятность появления i-го символа в сообщении.

Формула Хартли является частным случаем формулы Шеннона при одинаковой вероятности всех состояний.

В качестве единицы информации Клод Шеннон предложил принять один бит (англ. bit — binary digit — двоичная цифра).

За единицу количества информации принимается бит – это такое количество информации, которое содержится в информационном сообщении, уменьшающем неопределенность знания в два раза.

Производные единицы измерения количества информации. Минимальной единицей измерения количества информации является бит, а следующей по величине единицей - байт, причем:

1 байт = 8 битов = 23 битов.

В информатике система образования кратных единиц измерения несколько отличается от принятых в большинстве наук. Традиционные метрические системы единиц, например Международная система единиц СИ, в качестве множителей кратных единиц используют коэффициент 10n, где n = 3, 6, 9 и т. д., что соответствует десятичным приставкам "Кило" (103), "Мега" (106), "Гига" (109) и т. д.

В компьютере информация кодируется с помощью двоичной знаковой системы, и поэтому в кратных единицах измерения количества информации используется коэффициент 2n

Так, кратные байту единицы измерения количества информации вводятся следующим образом:

1 килобайт (Кбайт) = 210 байт = 1024 байт;

1 мегабайт (Мбайт) = 210 Кбайт = 1024 Кбайт;

1 гигабайт (Гбайт) = 210 Мбайт = 1024 Мбайт.

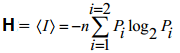

Энтропия одного сообщения численно совпадает с количеством информации и обозначается H.

Длясообщения, состоящего из n символов, в котором каждый символ имеет два состояния (m=2), формула для расчета энтропии имеет следующий вид

Различают две формы представления информации– непрерывную (аналоговую) и цифровую (дискретную).

Непрерывная формахарактеризует процесс, который не имеет перерывов и теоретически может изменяться в любой момент времени и на любую величину (человеческая речь, музыкальное произведение). Цифровой сигнал может изменяться лишь в определенные моменты времени и принимать лишь заранее обусловленные значения. Моменты возможного изменения уровня цифрового сигнала задает тактовый генератор конкретного цифрового устройства.

Связь: информация – сообщение - сигнал

Сообщение- это информация, выраженная в определенной форме и предназначенная для передачи от источника к пользователю (тексты, фото, речь, музыка, телевизионное изображениеи др.). Информация является частью сообщения, представляющая новизну, т.е. то, что ранее не было известно.

Сигнал- это физический процесс, распространяющийся в пространстве и времени, параметры которого способны отображать (содержать) сообщение.

Для передачи информации используют сигнал, который является физической величиной и с его параметрами так или иначе связана информация.

Таким образом, сигнал – это изменяющаяся определенным образом физическая величина. В телекоммуникационных системах и сетях используются электрические, оптические, электромагнитные и другие виды сигналов.

Дата добавления: 2016-03-27; просмотров: 2337;