Классификация ИНС.

ИНС – это набор нейронов, соединенных между собой. Как правило, передаточная (активационная) функция всех нейронов в сети фиксирована, а веса являются параметрами сети и могут изменяться. Подавая любые числа на входы можно получить какой-то набор чисел на выходе сети. Таким образом, работа ИНС состоит в преобразовании входного вектора Х в выходной вектор У, причем это преобразование задается весами сети.

В зависимости от функций, выполняемых нейронами в сети, можно выделить три типа нейронов: входные, промежуточные, выходные.

С точки зрения топологии ИНС можно выделить три основных типа сетей: полносвязные, многослойные или слоистые, слабосвязные (НС с локальными связями).

Полносвязные характеризуются тем, что каждый нейрон передает свой сигнал остальным, в том числе и самому себе. Выходными сигналами могут быть все или некоторые выходные сигналы после нескольких тактов работы НС.

В многослойных НС нейтроны объединяются в слои. К наиболее распространенным архитектурам НС относятся сети прямого распространения (сети без обратных связей).

Слой содержит совокупность нейронов с едиными входными сигналами. Число нейронов в слое может быть любым и не связано с числом нейронов в других слоях.

Среди слоистых ИНС выделяют следующие типы:

- монотонные. Это частный случай слоистых сетей с дополнительными условиями на связи и элементы. Каждый слой, кроме последнего, разбит на два блока – возбуждающий и тормозящий. Связи между блоками также разделяют на возбуждающие и тормозящие;

- сети без обратных связей (прямого распространения);

- сети с обратными связями.

По принципу структуры нейронов различают гомогенные и гетерогенные ИНС. Гомогенные состоят из нейронов одного типа с единой функцией активации. В гетерогенных ИНС нейроны имеют различные функции активации.

Существуют бинарные и аналоговые ИНС. Первые из них оперируют с двоичными сигналами, и выход каждого нейрона может принимать только два значения: логический ноль ("заторможенное" состояние) и логическая единица ("возбужденное" состояние). В аналоговых сетях выходные значения нейронов способны принимать непрерывные значения.

|

Различают также асинхронные и синхронные ИНС. В первом случае в каждый момент времени свое состояние меняет только один нейрон. Во втором – состояние меняется у группы нейронов, как правило, у всего слоя. ИНС можно классифицировать также по количеству слоев.

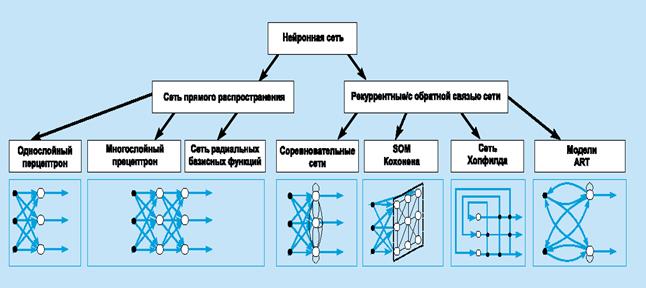

Рис. 2Систематизация архитектур сетей прямого распространения и рекуррентных (с обратной связью).

В наиболее распространенном семействе сетей первого класса, называемых многослойным персептроном*, нейроны расположены слоями и имеют однонаправленные связи между слоями. На рис. 2 представлены типовые сети каждого класса. Сети прямого распространения являются статическими в том смысле, что на заданный вход они вырабатывают одну совокупность выходных значений, не зависящих от предыдущего состояния сети. Рекуррентные сети являются динамическими, так как в силу обратных связей в них модифицируются входы нейронов, что приводит к изменению состояния сети.

. Нейронные сети можно классифицировать по числу слоев. Выбор структуры нейронной сети зависит от сложности задачи.

Сегодня под нейронными сетями (НС) понимаются параллельные вычислительные структуры, которые моделируют биологические процессы, обычно ассоциируемые с процессами человеческого мозга. НС обладают способностью приобретения знаний о предметной области, обучаясь на примерах и подстраивая свои веса для интерпретирования предъявляемых им многоразмерных данных.

На рис. 4 приведена структурная схема НС прямого распространения – многослойного персептрона. Кружками (вершинами) обозначены элементарные преобразователи информации – нейроны, а стрелками (дугами) – связи между ними, имеющие разную “силу” (веса синаптических связей). Как видно из рис., рассматриваемый персептрон состоит из нескольких слоёв нейронов:

• входного слоя, на который подаётся набор входных сигналов;

• одного или более “скрытых” (промежуточных) слоёв;

• выходного слоя нейронов.

Входной вектор подается на входной слой, а выходной определяется путем поочероедного вычисления уровней активности элементов каждого слоя с использованием реакцийц предыдущих слоев.

Особенности

нейроны каждого слоя не связаны между собой;

входной сигнал каждого нейрона поступает на входы всех нейронов последующего слоя;

нейроны входного слоя не осуществляют преобразование входных сигналов, их функции заключаются только в распределении сигналов между нейронами скрытого слоя.

Обучение сети «с учителем» состоит из следующих шагов:

1 Случайным образом инициализируются веса синаптических связей (наи практике из интервала [-0,05; 0,5]/

На входы НС поочередно подаются «образы» (входные векторы) обучающей выборки.

Вычисляется реакция НС на соответствующий входной вектор.

Вычисляется вектор ошибки сети – разность между желаемым и фактическим значением.

Вычисляется суммарная квадратичная ошибка.

Проверяется условие Е≤ Едоп., где Едоп- заданное условие ошибки.

Производится изменение весов НС в сторону уменьшения ошибки.

Более подробно этот алгоритм выглядит следующим образом:

Суть процесса обучения НС заключается в выполнении следующей многошаговой процедуры.

Шаг 1. Задаётся обучающее множество (“задачник”)

, элементами которого являются обучающие пары

, элементами которого являются обучающие пары  . В данном случае

. В данном случае  – 1-й входной вектор (или 1-й входной образ), предъявляемый нейронной сети;

– 1-й входной вектор (или 1-й входной образ), предъявляемый нейронной сети;  – вектор эталонных (требуемых) реакций НС в ответ на 1-й входной вектор

– вектор эталонных (требуемых) реакций НС в ответ на 1-й входной вектор  ; L – число различных обучающих пар.

; L – число различных обучающих пар.

Шаг 2. Устанавливается начальное состояние НС путём присваивания всем её весам  некоторых случайных (малых) значений.

некоторых случайных (малых) значений.  – вес связи, соединяющей выход i-го нейрона k-го слоя со входом j-го нейрона (k + 1)-го слоя.

– вес связи, соединяющей выход i-го нейрона k-го слоя со входом j-го нейрона (k + 1)-го слоя.

Шаг 3. На вход сети подаётся входной вектор  ; определяются реакции

; определяются реакции  нейронов выходного слоя.

нейронов выходного слоя.

Шаг 4. Вычисляется разность  между желаемой реакцией сети

между желаемой реакцией сети  и её фактическим выходом

и её фактическим выходом  , т. е.

, т. е.  , а также суммарная квадратичная ошибка

, а также суммарная квадратичная ошибка  .

.

Шаг 5. Осуществляется коррекция весов  нейронной сети таким образом, чтобы уменьшить ошибку

нейронной сети таким образом, чтобы уменьшить ошибку  .

.

Шаг 6. Повторяются шаги 3–5 для каждой пары обучающего множества  до тех пор, пока ошибка на всем множестве не достигнет малой, заранее заданной величины Е*.

до тех пор, пока ошибка на всем множестве не достигнет малой, заранее заданной величины Е*.

Результатом обучения является такая настройка весов синаптических связей, при которой каждому входному вектору сеть сопоставляет требуемый (или близкий к нему) выход.

Одним из первых алгоритмов, удачно зарекомендовавшим себя при обучении многослойной НС, явился предложенный в 1986 г. Руммельхартом Д. (США) и его коллегами алгоритм обратного распространения (Васk–Ргораgаtion Algorithm), претерпевший впоследствии многочисленные изменения и усовершенствования. Сущность этого алгоритма состоит в том, что подстройка весов осуществляется послойно, начиная с последнего(выходного) слоя и заканчивается первым скрытым слоем. Существуют также и другие алгоритмы обратного рспространения.

На сегодня известно более 200 разновидностей НС. Кроме упомянутых выше многослойных персептронов, это:

• динамические (рекуррентные) НС;

• сети на основе радиальных базисных функций;

• сети Хопфилда;

• сети Кохонена;

• неокогнитроны и т. д

Дата добавления: 2015-07-30; просмотров: 1501;